広報業務にChatGPTを活用する7つの方法【プロンプト付】

目次[非表示]

ChatGPTは広報戦略に関連する、さまざまなタスクを効率化できる人工知能(AI)です。

以前、広報・マーケティングにAIを活用するための10の方法というブログを公開しましたが、AI業界は日進月歩で変わっていくため、最新動向に合わせて少しアップデートしたいと思います。

2023年7月号の月刊広報会議でもChatGPT特集が組まれるなど、注目が集まっています。

ただしどのメディアも表面的な解説が多く、実務的な広報✕AIについて解説できている記事も少ないのが現状ではないでしょうか。

そこで、当ブログではAIにあまり詳しくない広報担当者やマーケティング担当者など非エンジニア層に向けて、最短距離でChatGPT系のLLM(大規模言語モデル)を使いこなすポイントについて解説してみたいと思います。

【2023/8/14更新】ChatGPTの新機能Code Interpreterを活用した雑誌部数分析の記事も追加しています。

【前提】GPT3.5とGPT4は全く違うもの

まずChatGPTが云々、という話をした際に、大きな誤解が生まれる要因の一つとして、「GPT3.5」を使っているユーザーと「GPT4」を使っているユーザーが混在している点が挙げられます。

「GPT3.5」を無料のみで使っている人は、ChatGPT=GPT3.5だと思っていると思いますが、GPT3.5とGPT4は全くの別物だと思ったほうが良いかと思います。

このブログでは精度の高いGPT4をベースとして解説を進めます(GPT4も精度が良い変わりに、高い/遅いといったデメリットがあるので場面に応じた使い分けが必要です)。

プロンプトエンジニアリングの罠

プロンプトエンジニアリングの大半は情報商材?

ChatGPTを少しいじくりだすと、必ず行き着くのが「プロンプトエンジニアリング」という世界です。

結論から言うと、この世界にはあまり足を突っ込まないほうが得策な気がしています。

というのもこれらの「一撃必殺プロンプト」「ゴールシーク」のようなものは、出力プロンプトが不安定なGPT3.5をいかにコントロールするか、ということに当初の主眼が置かれていたわけです。

しかしGPT4ではかなり制御が効くようになっていることから、ルールを記載する深津式プロンプトを最低限のベースにすれば、長ったらしいプロンプトは必要ないのではないかと思います。

プロンプトエンジニアリングを勉強するのであれば、アンドリュー先生の以下の動画をさらっと見るくらいが良いのではないでしょうか。

※ちなみにこの動画でもgpt-3.5-turboを基準として作成されているので、こうしたテクニックはすぐに陳腐化してしまう気もします。

ガチ実務で使える広報業務7つの方法

①プレスリリースなどの原稿作成/校正

テキストデータの作成にはすでに様々な手法が解説されていますが、プレスリリース作成に関しては、

- 第1段階(0 to 1) ※要素を整理してもらう

- 第2段階(1 to 10)※文字を生成してもらう

- 第3段階(校正とブラッシュアップ)※読みやすくしてもらう

と3段階に分けて考えるのが良いのではと思います。

【第1段階】ゼロベースの作成(0 to 1)

まず第一段階は、プレスリリースに必要な要素を漏らさず集約させるということを目標とします。

以下は一つのプロンプト例です。

GPT4であれば制約事項をほぼほぼ確実に守ってくれるため、プロンプトエンジニアリングによる制御もそこまで考えずにすみます。

>プロンプト例

あなたはユーザーと対話しながらプレスリリースを仕上げるプロの広報ライターです。

これから私に以下の質問をしながら情報をまとめ、最終的に100文字以内のタイトルと、3000文字程度のプレスリリース本文を作成し、マークダウン方式で出力してください。

#制約事項

-質問は1つずつ行うこと

-足りない情報があれば質問しながら補うこと

-情報が聞けない場合は、間接的な質問をしてそこから推測すること

-6W5H(who/whom/when/where/what/why/how/how much/how many/how long/how in the future)を確認すること

-その他盛り込むポイント:

新規性(New)/意外性(Surprising)/話題性(Topic)/地域性(Location)/希少性(Rare)/ストーリー性(Story)/社会貢献性(Social Contribution)

ポイントは6W5Hを聞かせること。そして1問ずつ質問させることです。

どんなに困難なタスクでも細分化すれば容易なタスクとなります。こうした前提をchatGPTに設定することは、プレスリリース以外でも様々なタスクで応用が可能です。

話題性を足したい場合は、賛否両論(50%vs50%)で意見が分かれるようなトピックを指定して盛り込ませることも良いかと思います(ただし、これはまだまだ人間がやったほうが良いかと思います)。

【第2段階】肉付け作成段階(1 to 10)

第2段階では先程作ったテキストを肉付けしていきます。

ストーリーを盛り込ませることが差別化ポイントとなり、非常に重要なポイントです。

この段階ではクリストファー・ボグラーや大塚英志氏などの「物語論」を参考にすると良いでしょう。

こうした物語論を企業に当てはめると、

・企業が直面した困難や挑戦

・どのようにしてこれら困難を克服したか

・そしてこれからどうするか

といった、いわゆるプロジェクトX的なストーリーが作れます。

ちなみにChatGPTにクリストファー・ボグラーの物語論を企業に当てはめてもらうと以下のようなエッセンスとなります。

- ビジョンと使命の明確化

- 挑戦や困難の設定

- 共感を呼ぶキャラクターの創造

- 情報の効果的な構成と伝達

- 感情的なつながりの形成

- 解決と成長の描写

- 記憶に残るエンディングの提供

これをそのまま使っても良いですし、以下のようにシンプルにしても良いかと思います。

>プロンプト例

あなたはプロの広報ライターです。これから下記プレスリリースのタイトルと概要を元に、内容を肉付けしていってください。

出力後に肉付けした具体要素を箇条書きで出力してください。#肉付けしたい要素:

-企業が解決したいと考えている具体的な社会的問題や課題

-この問題に対する認識や解決への意欲の発生ルート

-企業がこの問題に取り組む理由やその背後にあるモチベーション

-具体的に企業が行ったこと

-企業が直面した困難や挑戦

-企業はどのようにしてこれらの困難を克服したのか

-現時点での成果

-新たに得た学びや理解

-企業はこれらの成果や学びを今後どのように活用する予定か#タイトル:

●●#本文:

●●#出力:

プロンプトが出力した文章は出力根拠が分からなくなる場合があるので、「肉付けした具体要素を箇条書きで出力」として何に紐づいているのかを確認すると良いでしょう。

【第3段階】校正特化

第3段階は句読点や言い回しの修正として、読みやすい文章に校正していきます。

ポイントは点数化させること。永遠に改善してもしょうがないので数値化して進捗を把握し、ある程度満点に近くなるまで繰り返し処理を行います。

>プロンプト例

あなたはプロの校閲者です。

下の文章を読みやすさを100点満点で点数化し、改善点を箇条書きで出力してください。

またマークダウン方式で改善箇所に印を付けながら、改善後の文章全体を出力してください。

#タイトルと本文:

●●

以上で、だいぶしっかりとした原稿が出来上がったのではないでしょうか。

文体などはある程度プロンプト内でサンプルを提示することで、その文体に沿って作成することができるため微調整していただければと思います。

※最後はAIでチェック

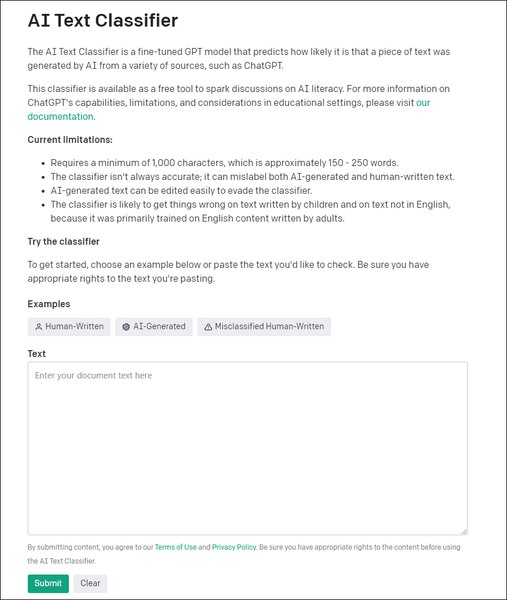

作った文書は、必ずAIによるチェックを入れましょう。

chatGPTの開発会社であるOpenAIは、AI Text Classifierというチェックモデルも公開しています。

このページに作った文章を入れて判定してください。恐らく上記のプロセスをたどると「The classifier considers the text to be possibly AI-generated.」などと表示されると思います。

つまりAIで作った文章は残念ながら大抵AI側で分かってしまうのです。

こうしたモデルをGoogleなどのSEO判断基準としても使っていることでしょうし、こうしたAIが作った文書はSEOなどにも弱いことが想定されます。

今は良いかもしれませんが、中・長期的にはAIで作られた文章だらけになることが想定されますので、必ず人間の手を加え、あえて人間臭く手直しするといった処理もマストとなるのではないでしょうか(新たなブルシットジョブでしょうか)。

②画像生成

テキストだけでなく、画像生成もAIの強みです。

著作権や倫理面、学習データなどを考慮すると、広報担当者が使う画像生成ツールは、Adobe FireFry一択になるような気もしますが、今のところLexicaでざっくりキーワードを入れて作りたいイメージ画像を探し、stable diffusionやBing Image Creator などの画像作成ツールなどにプロンプトをコピペして使うのがおすすめです。

(追記)2023年10月ChatGPTも作画AI「DALL·E 3」に対応し、かなり鮮明な出力が可能となりました。

DALL・E3出力

③SNSなどの口コミ分析(ネガポジ分析)

自然言語処理であるChatGPTは、SNSなどの口コミ分析をするのにも向いています。特にアスペクトベースの感情分析と呼ばれるタイプの感情分析に効果を発揮するようです。

アスペクトベースの感情分析とは

アスペクトベースの感情分析とは、テキスト全体のネガポジではなく、特定の側面においてのネガポジを分析するものです。

例えば「このレストランは美味しいが、接客が悪い」といった口コミがあった場合、味に感してはポジティブですが、接客はネガティブと判断されるべきです。

テキストデータをネガポジ分析するには、以前の記事でも紹介させていただいたGoogle Natural LanguageやAmazon ComprehendなどのAIツールが有名です。

実際に「このレストランは美味しいが、接客が悪い」というワードを、Google Natural Languageにかけると、Scoreが-0.5(ネガティブ)、Magnitudeは0.5と判定され、Amazon Comprehendでは、"Mixed": 0.9998151659965515と判定されます。

しかしこれでは、味や接客それぞれの評価は分かりません。

そこで活用したいのが、ChatGPTを活用した「アスペクトベースの感情分析」です。

ちなみにアスペクトベースの感情分析の評価には、ある程度の大きさのネガポジとアスペクトのラベルが付いたデータセットが必要となります。

これにちょうど良さそうなのが、Twitterの投稿データをまとめた「日本語評判分析データセット」です。

iPhone/Xperia/AQUASなどのスマホブランドのほか、ルンバやシャープ、パナソニックといったブランドごとのアスペクトがラベル付けされています。

このデータセットから下記投稿を取り出して実験してみます。

iPhoneって ホント壊れないし快適。

旦那のXperiaは すぐ故障してる。

やっぱりiPhone♪♪(´ε` )

この投稿をGPT4にかけて分析してみます。

タスクがアスペクトベースの感情分析であることを明示し、投稿者の感情とアスペクト(iPhone/Xperia)に関する感情をそれぞれ抽出します。

>入力プロンプト

#指示 :

あなたはiPhoneの有能な広報担当です。

アスペクトベースの感情分析として、以下の#入力文に記載したTwitter投稿が、アスペクト:iPhoneにとってポジティブな情報かネガティブな情報か、またはニュートラルな情報かを一言単語のみで出力してください。

なおよく比較される競合/サービスは、Xperia/Aquosなどが挙げられますので、それら競合との比較文脈も考慮してください。

#制約事項(step by stepで1行目から実施):

1.投稿者の感情に対しての次の3種の感情を判断して一単語で出力 ・ポジティブ ・ニュートラル ・ネガティブ

2.アスペクト:{会社名/サービス名}に対しての次の3種の感情を判断して一単語で出力 ・ポジティブ ・ニュートラル ・ネガティブ

*競合他社と比較して{会社名/サービス名}のほうが良いと書かれているものはポジティブに判定すること

3.投稿者の感情度合いからリスクを0~1までの浮動小数点第二位までを数値で出力

*違法や脱法に関するもの、ルール無視や衛生面での投稿はリスク度を上げて判定すること

4.iPhoneに対しての感情判断の根拠を改行してからテキストで出力

#入力文:

iPhoneって ホント壊れないし快適。

旦那のXperiaは すぐ故障してる。

やっぱりiPhone♪♪(´ε` )

#Output:

iPhoneに対する出力がこちら

>出力

ポジティブ

ポジティブ

0.01

投稿者はiPhoneの耐久性と快適さを高く評価しており、競合製品のXperiaに対しては故障の頻度が高いと述べています。これにより、投稿者がiPhoneに対してポジティブな感情を持っていることが示されています。

アスペクト対象を、iPhoneからXperiaに変えて出力してみます。

>出力

ネガティブ

ネガティブ

0.70

投稿者はiPhoneを持ち上げ、その耐久性と快適さを強調しています。一方で、Xperiaについては故障しやすいという形で否定的に述べています。そのため、Xperiaに対する感情はネガティブと判断します。

このようにGPT4を使うとかなり安定して出力することができ、下記のようにAPIを使えば大量データにも対処できます。

ただし大きな問題点は、GPT4のAPIは遅い&高いということです。

このあたりが早く改善されれば、定期的にTwitterを取得しネガポジ分析するようなことも可能になるでしょう。

APIを使ったネガポジ分析プロンプト例

④記事の分類と評価

口コミ分析同様、記事の論調を分析するのも効果的でしょう。GPT4にはプラグインが提供されており、ブラウズ機能をオンにすることでURLから論調を取得することができます。

ただし、WEBサイトの構造によっては、全く違う記事のデータとして取得してしまうケースもあるようで、さらなる安定化に期待です(東洋経済オンラインなどはなぜか正常に取得できません)。

以前、記事の論調分析ツールとして、IBMのWatson Discoveryニュースがありましたが、サービス停止となってしまったため、こうしたツールに変わるものが出てくることにも期待です。

⑤chatbot/カスタマー応対

GPTモデルは、chatbotやカスタマー応対に活用するとかなりいい感じです(このブログに埋め込んでいるchatbotもGPT4モデルです)。

こうしたchatbot系はいかに自社データを学習させるか(正確にはプロンプトに入れるか=embedding)が重要ポイントとなるようです。

embeddingを使うと以下のような独自回答が可能となります。※embeddingについては後述します。

⑥ペルソナ作成

chatGPTはデモグラ情報などからユーザーを推測することも得意です。

例えば検索データを取得できるDS.Insightなどで取得できるデモグラ情報を、直接突っ込むだけでペルソナを作成してくれます。

自社のデータがある場合は、CSVデータ等をコピペしてそのまま貼り付けてみるのも良いと思います。

プラグインcode interpreterでデータ分析も可能に

ChatGPTを使ったデータ分析として、ベータ版プラグインであるCode Interpreterがデータ分析の世界を変えてしまうと話題です。

(追記)下記記事では実際にCode Interpreterを使って雑誌の印刷部数を分析してみました。

こうしたツールの登場で、データ可視化そのもののテクニックはコモディティ化し、正確な統計知識をもとにした意思決定が、より重要となってくるのではないでしょうか。

⑦SNSなどのデータ分析

chatGPTはデータ分析全般が得意ですが、なんとTwitterアナリティクスのデータをそのままコピペで突っ込むだけで、概況をまとめてくれます。

特に「by tweet」データは個別投稿の相関などを指摘してくれるため、参考になります。

ChatGPTの差別化ポイント

Embedding

chatGPTの差別化ポイントは、(現時点では)どうやら「embedding」というものにありそうです。

embeddingとはそのまま訳すと「埋め込み」となってしまいますが、chatGPTなどで使われる際は「単語や文章など任意の一括りのテキストデータを数値化する」という意味合いで使われるようです。

仕組みとしては、

- 単語や文章など任意の一括りのデータを数値化(ベクトル化)する

- 数値化すると似ている単語や文章が探せる(コサイン類似度)

- プロンプトを投げかける際に、似ている文章データをカンニング的に一緒に渡す

例えば実際にエアコンメーカーのQ&A chatbot を作るとします。するとこんな流れになります。

- Q&Aの質問と回答のテキスト情報を作成しておく(例えば、Q.エラーメッセージE01が出た場合どうしたら良い? A.人体センサーの故障なのでオペレーターを呼んでください、等)

- このQ&Aテキストデータを大量に作っておき、数値化(ベクトル化)して一旦ストックしておく

- ユーザーがchatbotから質問を入力する(この時点ではユーザーは「エラーメッセージE01が出た」と入力したと想定)

- 質問プロンプトを数値化し、その質問と似た文章をいくつかデータベースから引っ張ってくる(「エラーメッセージE01」というワードが共通しているため、類似度が高い文章として「Q.エラーメッセージE01が出た場合どうしたら良い? A.人体センサーの故障なのでオペレーターを呼んでください」という内容上位に上がる確率が高い)

- 質問プロンプトにこの文章を加え、「この文章を参考に答えてください」と追記してGPTに送る(つまりカンニング状態を作る)

こうしたembedding処理によって、chatGPTは当初個別の"エラーメッセージE01"という情報は持っていませんが、意図的にカンニング状態を作ることで、個別の質問にもいくらでも答えられるようになるわけです。

OpenAIのembedding専用モデルとして、数学者エイダ・ラブレスから命名した「text-embedding-ada-002」というものがあります。

エイダ・ラブレス

このモデルはある一括りの単語や文章を1536次元(1536個の小数点の数値)に置き換えるもので、実際にエラーメッセージE01を人体センサーの故障、エラーメッセージX44を室外機の故障、その他返品についてのQ&Aを作ってみた際のembeddingはこちらになります。

内容 |

テキスト情報 |

embedding(省略しているが実際は1536個の小数点の羅列) |

類似度 |

|---|---|---|---|

質問文 |

エラーメッセージE01が出た |

[-0.006972969975322485, -0.022527042776346207,... |

0 |

Q&A1 |

Q.エラーメッセージE01が出た場合どうしたら良い? A.人体センサーの故障なのでオペレーターを呼んでください |

[0.005040374584496021, -0.003836358431726694, ... |

0.113660 |

Q&A2 |

Q.エラーメッセージX44が出た場合どうしたら良い? A.室外機の故障の可能性があります |

[0.0027355975471436977, -0.004078647121787071,... |

0.162891 |

Q&A3 |

Q返品に対応していますか? A.お客様のご都合による良品の返品・交換は基本的にいたしかねます。 |

[-0.00046157799079082906, -0.00428672600537538... |

0.239955 |

質問文である「エラーメッセージE01が出た」に類似度が一番近いものとして、エラーメッセージE01のQ&A文章が選ばれる結果となりました。

実際にGPTにプロンプトを送る際は、下記のようなイメージとなります。

>入力プロンプト

あなたはエアコンの故障等に対応する有能なカスタマー対応チャットボットです。

下記の質問に対して以下の情報をコンテキスト情報として回答してください。

#コンテキスト情報:(※ここの部分をコードで後付けする)

Q.エラーメッセージE01が出た場合どうしたら良い? A.人体センサーの故障なのでオペレーターを呼んでください

#質問: エラーメッセージE01が出た

#回答:

>GPT4の出力

エラーメッセージE01は人体センサーの故障を示しています。この問題を解決するには専門のオペレーターを呼ぶことが必要です。

embeddingに関しては、中島聡氏がメルマガ内で解説しています。

こうしたembeddingを使ったプロンプトを送信するには、embedding処理だけでなく、プロンプトの文字サイズなどを考慮して行う必要があります。こうした一連の流れをまとめて行ってくれるライブラリが、「LlamaIndex」や「LangChain」などです。

このあたりのツールに関しては、近々解説書籍が出るようです。

ここまでのまとめとしては、

- embeddingを使うと自社に特化したオリジナルchatGPTが作れる

- 自社データをいかにテキストで貯めるかが最初の鍵

- 貯めたテキストデータは数値化してデータベースにする

Pinecone

なおLlamaIndexは実際に使ってみると相当遅いです。

こうした問題はPineconeというベクトルデータベースサービスを使うことで、膨大なベクトルデータを効率的に保存・管理しながら、高速に検索することができるようです。

PineconeはJSONデータを基本として扱うようなので、JSONスキルも今後より重要となるような気もします。

以上embeddingに関してのまとめでした。

色々と学ぶべきことが多すぎて目眩がしてきますが、最後にAI関連でフォローすべき人を何人か紹介して終わりにしたいと思います。

文系でもフォローすべきAIスペシャリスト

中島聡さん

ビジネスパーソンの火曜日のメルマガといったら、ウインドウズ95を作った天才エンジニア中島聡さんと角川社長の夏野剛さん。火曜日が楽しみというビジネスパーソンも少なくないのではないでしょうか。

中島聡さんは実際にGPT APIを触りながら、メルマガ上でembeddingの解説をしてくれる唯一のスペシャリストで、めちゃくちゃためになります。

ご子息がBaby AGIを開発したということもあり、中島聡さんのGPT解説はめちゃくちゃ貴重な情報です。

中島聡さんと金融系のまりーさんとの掛け合いトークもめちゃくちゃためになります。

清水亮さん

こちらも天才ハッカーでありUberEats配達員の清水亮さん。元々ディープラーニング界隈の達人なのでそこらへんのAIツイッタラーとは素地が違います。

清水さんが書くGPT APIのPythonコードも非常に参考になります。

尾原和啓さん

元々京都大学で人口知能研究を手掛けていた尾原和啓さん。テクノロジーとビジネスの関係性を説明させたらこの人に叶う人はいないのではないでしょうか。

オンラインサロンのコンテンツも充実です。

以上、広報業務にChatGPTを活用する7つの方法でした。

書いているうちにembeddingに大きく寄り道してしまいましたが、今後embeddingの活用がchatGPTなどのAI活用の大きな差別化ポイントになると感じています(openAIは来年には100万tokenのGPTを提供すると発表しており、大量のヒントを与えながら回答させる流れが主流になるのかもしれません)。

全ての技術はやがてはコモディティ化を迎えてしまうかとは思いますが、こうした技術をいち早く学んでおくのも良いのではないでしょうか。

▼合わせて読みたい